Les 4 modes d’utilisation d’une IA générative à connaître pour éviter le « botshit »

Par Kévin Deniau

13 juin 2024

Comment utiliser l’IA générative de la meilleure des façons… en atténuant ses risques « d’hallucinations » ? Des chercheurs apportent une réponse à travers un modèle qui croise la capacité à vérifier les informations générées par l’IA à l’importance de l’enjeu de ces informations. Utile à l’heure de l’expansion rapide de ChatGPT et consorts.

« Botshit ». L’expression n’est pas des plus heureuses mais elle a le mérite d’être parlante. Évoquée dans cet article du Guardian par le professeur à la Bayes Business School de Londres, André Spicer, elle correspond sommairement à la faculté de dire n’importe quoi non pas des humains (« bullshit ») mais des machines ! Un phénomène évidemment lié à l’émergence spectaculaire au cours de la dernière année de l’intelligence artificielle (IA) générative.

Rappelons en effet que ces modèles sont probabilistes. Une IA générative répond aux questions qu’on lui pose en faisant des suppositions basées par des statistiques. Elle ne cherche pas le vrai ou le faux (elle n’est pas en capacité de le savoir) mais le plus probable. Souvent, ses réponses sont correctes. Mais parfois, ce n’est pas le cas – malgré leur cohérence apparente. C’est ce qu’on appelle des « hallucinations ».

Lorsque les humains utilisent ce contenu mensonger pour des tâches, cela devient ce que nous appelons de la « botshit » », indique André Spicer.

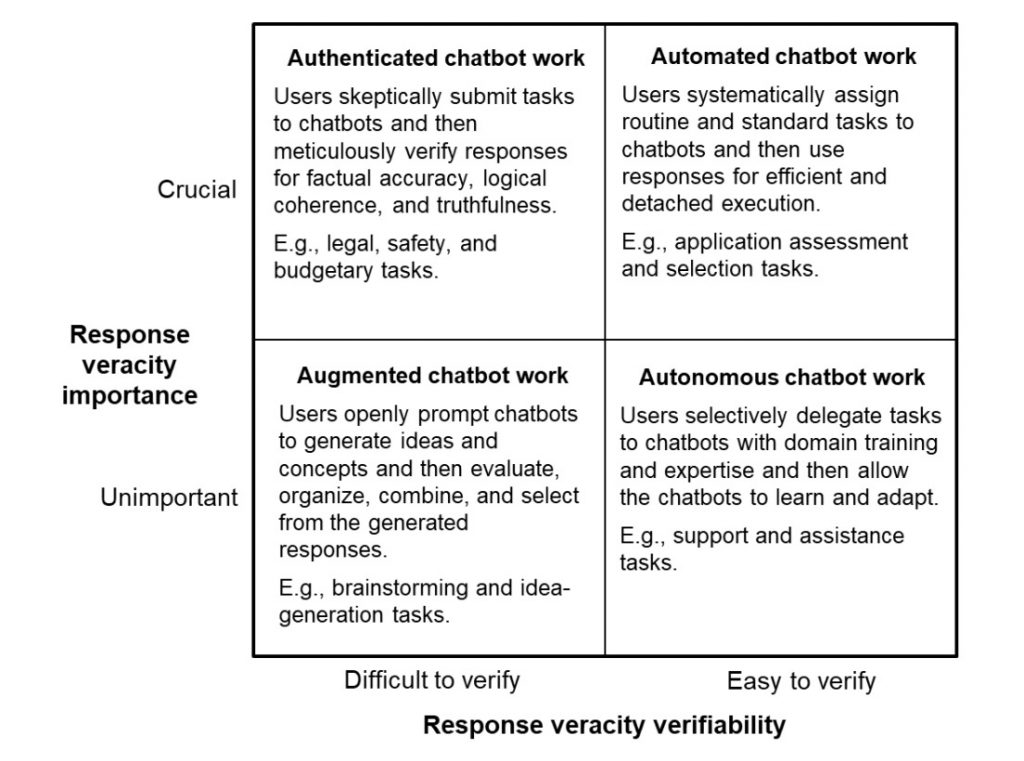

Partant de ce constat, le chercheur propose avec deux de ses collègues, dans un article académique paru il y a quelques mois, d’identifier les cas d’usage de l’intelligence artificielle générative afin d’atténuer ces risques. Il en découle un modèle en deux dimensions :

- La capacité à vérifier la véracité des réponses

- Et l’importance de la véracité des réponses

En conséquence, il existe quatre situations différentes de collaboration entre les humains et les IA génératives.

1- Mode « autonome » – tâche facilement vérifiable et à faible enjeu

Dans ce premier mode, l’utilisateur peut déléguer des tâches spécifiques à la machine en les vérifiant rapidement, ce qui est susceptible d’augmenter la productivité et d’éliminer les tâches routinières. Les auteurs citent par exemple des demandes courantes de clients ou le traitement de demandes administratives courantes.

2- Mode « augmenté » – tâche difficilement vérifiable et à faible enjeu

Dans ce cas, l’utilisateur devrait utiliser la réponse générée par l’IA de manière augmentée, c’est-à-dire qu’il devrait les utiliser pour « augmenter » ses capacités humaines. On pense évidemment ici aux exercices créatifs de remue-méninges et de génération de nouvelles idées. Les réponses ne sont pas pleinement exploitables en l’état mais, triées, modifiées et retravaillées, elles peuvent aider à gagner en productivité et en créativité.

3- Mode « automate » – tâche facilement vérifiable et à grand enjeu

Comme la véracité de l’information est cruciale ici, les utilisateurs doivent vérifier les réponses de l’IA. Ces derniers lui attribuent alors des tâches simples, routinières et relativement standardisées. Les auteurs parlent d’une forme de contrôle de qualité et citent l’exemple de l’analyse et la pré-approbation des demandes de prêt dans une banque.

De grandes quantités d’informations pourraient être utilisées pour vérifier les déclarations faites. Cependant, la décision sera probablement relativement cruciale et à enjeux élevés. Cela signifie que même si le chatbot peut produire automatiquement une déclaration véridique, celle-ci doit encore être vérifiée et approuvée par un banquier formé », indiquent-ils.

4- Mode « authentifié » – tâche difficilement vérifiable et à grand enjeu

Dans ce dernier cas – celui qui pose le plus de problèmes, les utilisateurs doivent établir des garde-fou et garder leur pensée critique et leur capacité de raisonnement pour estimer la véracité des réponses de l’IA.

Dans ces contextes, les utilisateurs doivent structurer leur engagement envers la réponse du chatbot et adapter les réponses au fur et à mesure que les (in)certitudes se dévoilent », expliquent les auteurs.

Exemple ? Une décision d’investissement dans une nouvelle industrie avec peu d’informations précises – difficile donc de vérifier les réponses d’une IA en la matière. Les robots peuvent mettre en lumière des détails ou des problèmes négligés, ajoutant de la profondeur et de la rigueur aux décisions critiques, surtout dans des situations incertaines ou ambiguës.

Un modèle très facile à appliquer dans ses interactions avec l’IA !

Découvrez nos formations :

Sur le même thème

chatgpt • IA • intelligence artificielle